- AVANT-PROPOS

- A la UNE

- PRESENTATION

- ACTUALITE SCIENTIFIQUE et TECHNOLOGIQUE

- ACTUALITE ARTISTIQUE

- BLOG

- CONSCIENCE

- PLANETE VIVANTE

- SCIENCES

- Sciences et histoire

- Science et politique

- Science/conscience

- Médecine de demain

- Le COVID-19

- COVID-19 - Journal d'une pandémie - 1 -

- COVID-19 - Journal d'une pandémie - 2 -

- COVID-19 - Journal d'une pandémie - 3 -

- COVID-19 - Journal d'une pandémie - 4 -

- COVID-19 - Journal d'une pandémie - 5 -

- COVID-19 - Journal d'une pandémie -6 -

- COVID-19 - Journal d'une pandémie - 7

- COVID-19 - Journal d'une pandémie - 8

- COVID -19 - Journal d'une pandémie - 9

- COVID-19 - Journal d'une pandémie - 10

- COVID-19 - Journal d'une pandemie - 11

- Arts et sciences

- L'homme debout

- Les débuts de la sagesse

- L'épopée scientifique

- Chimie, vivant... une si longue histoire !

- Introduction : 52 choses que je sais d'elle

- Sommaire

- 1 - Premiers pas

- I - A l'origine

- II - De la tetrasomia et l'alchimie à la chimie moderne

- III - al-kimiya

- IV - Alchimie : de l'aube à la fin de la Renaissance

- V - De l'(al)chimie à la chimie : une question de méthode ?

- VI - L'alchimie selon Newton, première partie

- VII - L'alchimie selon Newton, deuxième partie

- 2 - La chimie des Lumières

- XI - Chimie au siècle des Lumières - Introduction

- XII - Chimie au siècle des Lumières- Les affinités électives

- XIII - Diderot et la chimie

- XIV - Diderot - La chimie, pourquoi ?

- XV- Diderot chimiste

- XVI- La chimie et le Rêve de D'Alembert

- 3 - La chimie du vivant

- X - Chimie et Vivant - Introduction

- XIX - La génération spontanée

- XX - Fermentation : duel à 3 !

- XXI - Stéréochimie : clé du Vivant

- XXII - Homochiralité et origine de la vie

- XXIIc - Origine de la vie : état des lieux... provisoire

- XXIIb - Des biopolymères aux premiers organismes vivants

- XXIII- Stéréochimie et activité biologique

- XXIV - Chimie du cerveau - 1- Un cerveau, trois cerveaux, des cerveaux...

- XXV - Chimie du cerveau - 2 - Les neurotransmetteurs, messagers chimiques

- XXVI- Chimie du cerveau -3- Rôle des différents neurotransmetteurs

- XXXIV - Odorat, Odeurs et parfums

- XXXV- Bonnes et mauvaises odeurs

- XXXVI - Chimie et parfums

- XLIII - Chimie et couleur -1- De colore

- XLIV - Chimie et couleur -2- Couleurs végétales

- XLV - Chimie et couleur -3- : chimiothérapie et colorants

- XL- a - ADN, ARN, protéines

- XL- b - Chimie supramoléculaire

- XXXIX- Chimie et Synthetic Biology

- XLVI - Du génome au protéome

- 4 - Chimie et médecine

- VIII - Chimie et médecine : d'Hippocrate à Néron

- IX - Chimie et opium : voyages, voyages !

- XVII- Médecine et Chimie à Montpellier avant la Révolution

- XVIII - Le vitalisme de l'Ecole de Montpellier

- XXIX - Le médicament aujourd'hui

- XXVII - Autour de la sérotonine

- XXVIII - L'ocytocine

- XXX - Chimie, médecine, nanotechnologies

- L - Chimie et dopage -1- La chimie au service du dopage

- LI - Chimie et dopage - 2 - Les outils du chimiste contre le dopage

- XLIX - Image magnétique - 3 - de l'IRM au patient numérique

- 5 - La chimie moderne et ses hommes

- XXXI - Mendeleïev : un tableau de maître !

- XXXII - Mendeleïev : -2- Un chimiste russe au XIXème siècle

- XXXIII - Mendeleïev -3- Le fin mot de l'histoire

- XLI - Paul Sabatier, chimiste languedocien, prix Nobel 1912

- XLII - Victor Grignard, prix Nobel 1912

- XLVII - Image magnétique - 1 - Une histoire de spin

- XLVIII - Image magnétique - 2 - Mais que vient faire le chimiste dans cette galère ?

- 6 - Chimie : bonnes et mauvaises pratiques

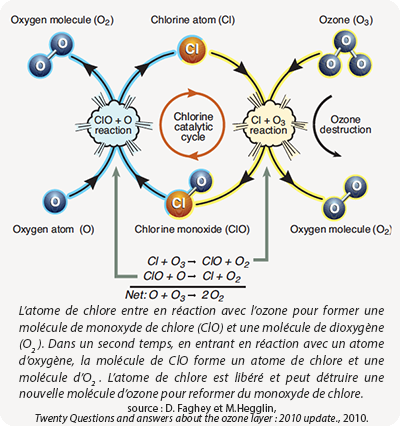

- XXXVII- Du mauvais usage de la chimie

- XXXVIII- La chimie passe au vert

- Pour conclure

- Postface - Nylon by DuPont de Nemours

- Nylon... - Part A

- Nylon... - Part B

- Nylon... - Part C

- Nylon... - Part D

- La beauté des mathématiques

- Les sciences vers La Science

- La révolution numérique

- CRISPR-Cas9 : l'édition de gènes

- L'ombre de Frankenstein

- VOIR

- RECHERCHE, CONTACT

Je vais ici brièvement évoquer les pistes suivies pour accéder rapidement à une économie plus respectueuse de notre environnement, de nos ressources, de la biodiversité, créatrice d'emplois et de mieux-être.

SEULE susceptible de redonner espoir et confiance aux jeunes générations.

En m'appuyant sur des sources primaires incontestables, je vais donc faire un état des lieux dans 5 domaines fondamentaux pour l'avenir proche de notre planète :

I - Les énergies renouvelables en 2018

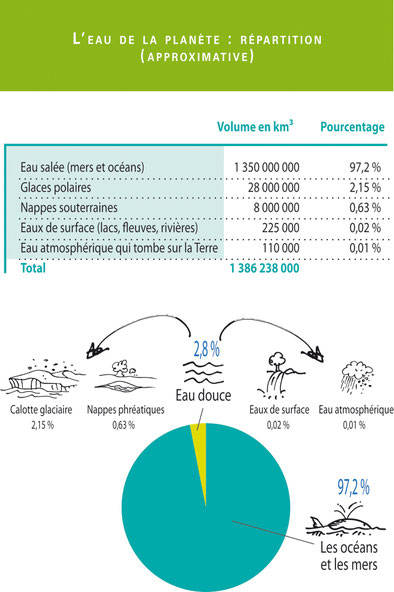

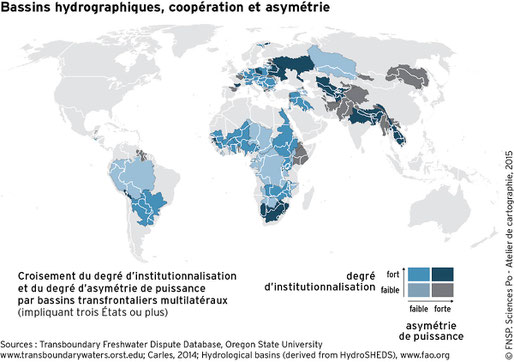

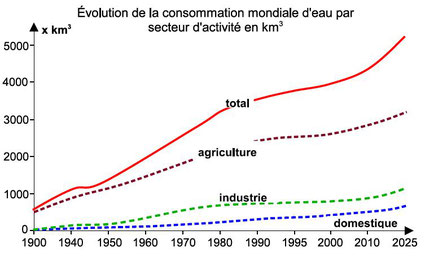

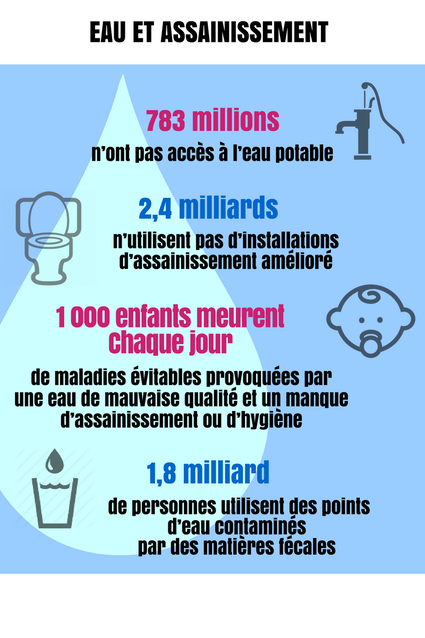

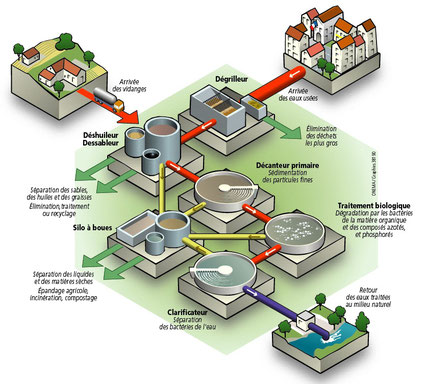

III - La gestion de l'eau

IV- L'économie circulaire (voir partie II)

V - Une construction durable (voir partie II)

L'abondance des publications pertinentes, avec leurs avalanches de chiffres, ne facilite pas la synthèse. Je n'ai donc retenu que les données les plus récentes, sur les points essentiels, en les illustrant le plus clairement possible.

Je me situerai à 3 niveaux : monde, Europe, France.

I - Les énergies renouvelables en 2018

Place des EnR

Dans le monde

Les derniers chiffres validés par REN 21 (Renewables 2018 Global Status Report pour la consommation totale d'énergie dans le monde sont résumés dans le tableau ci-contre.

L'analyse fine des données fait apparaître des bonnes et des mauvaises nouvelles :

- la bonne :

Les EnR (énergies renouvelables) représentaient 70% des ajouts nets à la capacité globale de production d'énergie en 2017.

La dynamique dans le secteur de l'énergie est positive, c'est le moteur de changement rapide vers un avenir d'énergie renouvelable

- la mauvaise :

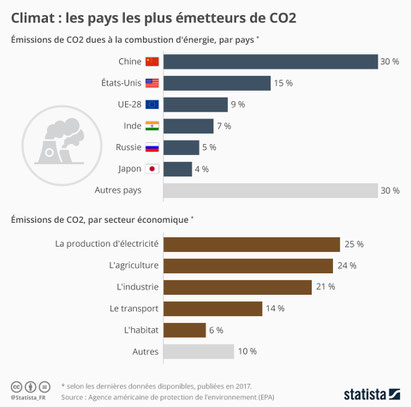

Les émissions globales de dioxyde de carbone liées à l'énergie ont augmenté de 1,4% en 2017, après trois ans de stabilité. C'est le résultat d'une croissance économique mondiale forte (3,7%), de la baisse des prix des combustibles fossiles et de plus faibles efforts d'efficacité énergétique.

Ainsi, alors que la dynamique dans le secteur de l'énergie est positive, elle ne permettra pas les réductions d'émissions exigées par l'accord sur le climat de Paris. Les secteurs du chauffage, du refroidissement et des transports, qui représentent ensemble environ 80% de la demande mondiale d'énergie finale totale, en sont responsables.

La Chine est le leader dans le solaire photovoltaïque, où elle est à l’origine de près de la moitié des capacités supplémentaires, comme dans l’éolien, où plus de 40 % des nouvelles installations sont à mettre à son actif.

Le Japon, les Etats-Unis, l’Allemagne ou l’Inde sont loin derrière.

La France est dans le groupe des dix pays les plus équipés, mais avec une production de nain et une progression faible (+ 0,6 GW en 2016 dans le solaire et + 1,6 GW dans l’éolien).

En Europe

Dans son action pour le climat, l'Europe a pris des engagements à l'horizon 2020 :

Le paquet énergétique fixe trois grands objectifs:

- réduire les émissions de gaz à effet de serre de 20 % (par rapport aux niveaux de 1990);

- porter à 20 % la part des énergies renouvelables dans la consommation d'énergie de l'UE;

- améliorer l'efficacité énergétique de 20%.

et à l'horizon 2030 :

Le cadre pour le climat et l'énergie à l’horizon 2030 fixe trois grands objectifs pour 2030:

- réduire les émissions de gaz à effet de serre d'au moins 40 % (par rapport aux niveaux de 1990);

- porter la part des énergies renouvelables à au moins 27 %;

- améliorer l'efficacité énergétique d'au moins 27 %.

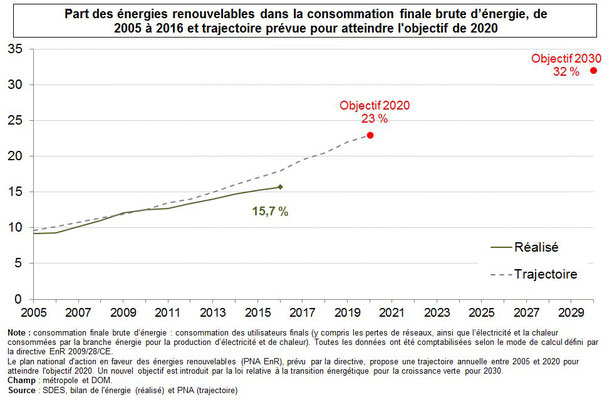

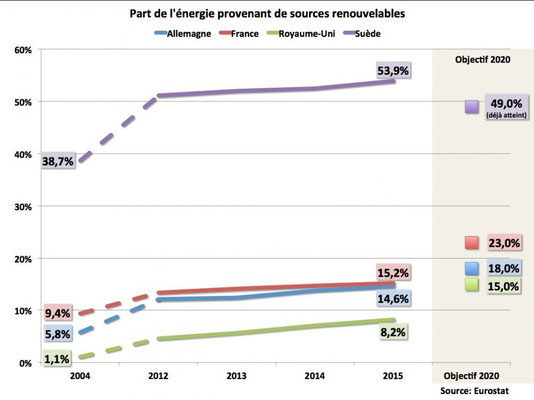

Le diagramme ci-dessus donne le rapport d'étape pour 2017.

On constate que les pays plus vertueux (les pays nordiques) ont d'ores et déjà atteint leurs objectifs, alors que l'Allemagne et surtout la France en sont loin. A noter que la Grande Bretagne est à moins de 10% d'EnR dans son mix énergétique.

Les figures ci-dessous permettent de visualiser les trajectoires et de confirmer que les trois grands pays européens sont à la traîne. La France n'atteindra pas son objectif 2020.

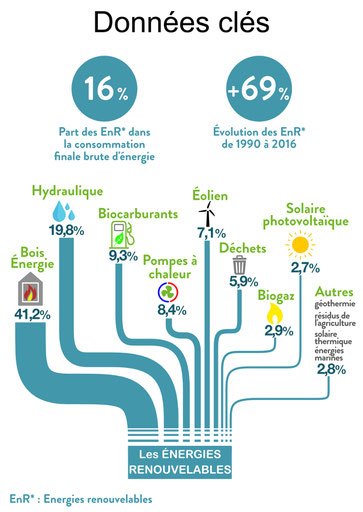

En France

Les chiffres les plus récents (publication 2018) donnent la ventilation des EnR consommées en France. Elles ne représentent que 16% de la consommation globale brute (la progression affichée n'a pas grand sens, dans la mesure où nous partons de très bas).

C'est de loin la filière bois/énergie (plus de 40% de l'ensemble) qui tient la palme devant l'hydraulique (près de 20%). Toutes les autres sources d'EnR sont en dessous de 10%.

Le bois énergie désigne l'utilisation du potentiel énergétique du bois afin de produire de la chaleur (chauffage, eau chaude sanitaire), de l'électricité voire des biocarburants de seconde génération. Cette bioénergie, disponible sous différentes formes (granulés, bûches, etc.), présente un avantage essentiel en terme écologique : son bilan carbone est totalement neutre, puisqu'un arbre consomme autant de CO² durant sa croissance qu'il en produit lors de sa combustion.

Les forêts françaises couvrent 15,5 millions d'hectares, ce qui équivaut à près du tiers de la surface du territoire. Le prélèvement annuel de bois (environ 50 millions de mètres cube) représente à peine plus de la moitié de l'accroissement naturel de la forêt. De quoi offrir à la filière bois énergie un important gisement énergétique potentiel. Source : Office National des Forêts (ONF).

Les investissements

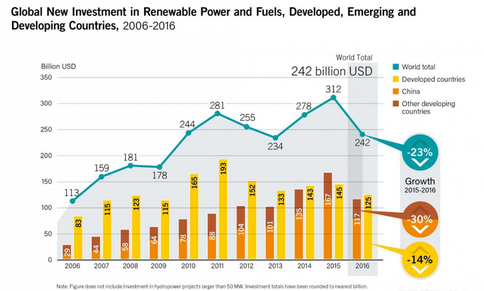

Les énergies issues du soleil, du vent ou de la biomasse ont sérieusement progressé alors que les investissements qui leur sont consacrés sont en chute libre. Ceux-ci ont en effet reculé de 23 % en 2016, pour revenir à 242 milliards de dollars , soit leur niveau de 2010.

Le recul est très significatif pour les pays développés (– 14 %), mais il est particulièrement prononcé pour les pays émergents et en développement (– 30 %).

Ce résultat est lié à la baisse des coûts des technologies renouvelables qui permet d’avoir « plus de capacité pour moins cher »... mais aussi à une très inquiétante faiblesse des investissements publics.

En effet, si les investissements mondiaux dans les renouvelables sont désormais environ deux fois plus élevés que ceux alloués aux fossiles (charbon, gaz et pétrole), le ratio est inversé au niveau des subventions publiques.

Les derniers chiffres harmonisés, cités par REN 21, font état de 490 milliards de dollars d’aides publiques pour les secteurs fossiles, contre seulement 135 milliards pour les renouvelables. Un ratio de presque quatre pour un.

Donc si « la transition énergétique ne s’effectue pas assez vite pour atteindre les objectifs de l’accord de Paris » ce sont les ETATS signataires de cet accord, qui en sont principalement responsables, alors que les investisseurs privés jouent le jeu.

En FRANCE

En France, la somme des dépenses publiques de soutien aux EnR est estimée pour 2016 à 5,3 Md€. Si elle réalise la trajectoire qu’elle s’est fixée, les dépenses relatives aux EnR électriques pourraient atteindre 7,5 Md€ en 2023. (Rapport de la Cour des Comptes, mars 2018). Au sein du G20, cela constitue une performance.

MAIS la France soutient encore les énergies fossiles de manière directe et indirecte.

Cela passe surtout par des exonérations fiscales bénéficiant à certaines énergies (diesel) et certains secteurs (gazole poids lourds, kérosène, gazole non routier, taxis, etc.), qui ont coûté 7,8 milliards en 2017 selon l'ONG Réseau Action Climat.

Des structures dépendant de l'Etat investissent par ailleurs dans des projets d'énergies fossiles, comme EDF (détenue à plus de 80 % par l'Etat), qui investit 1 milliard par an dans les fossiles.

La France soutient aussi des projets similaires dans le cadre des banques européennes d'investissement (BEI et BERD).

L'emploi

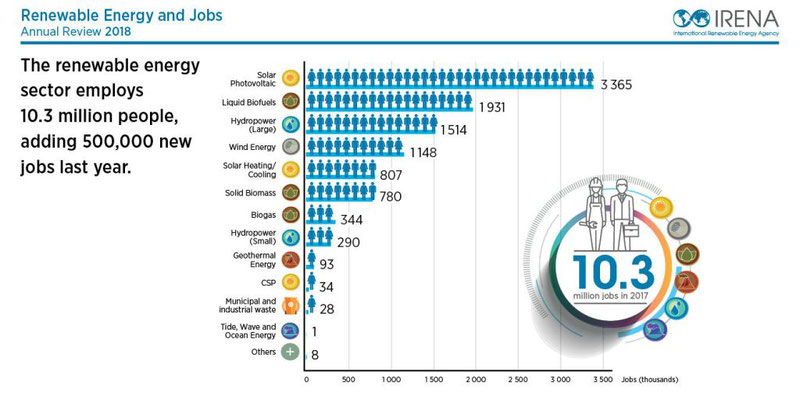

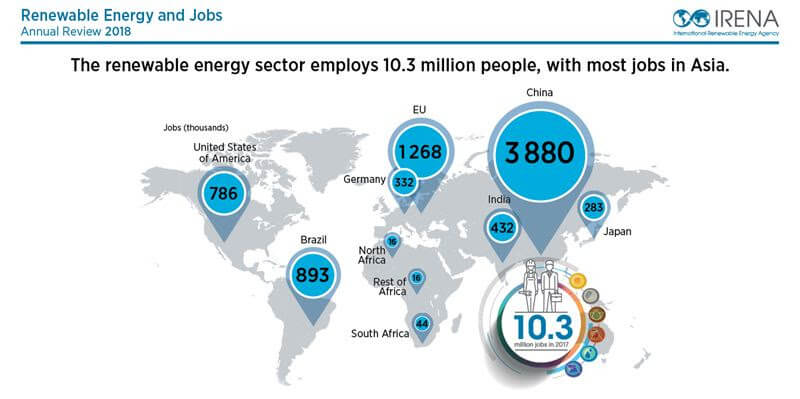

Pour la première fois, le cap des 10 millions d’emplois a été franchi en 2017, selon les derniers chiffres (2018) publiés par l’Agence internationale pour les énergies renouvelables (Irena). Toutes filières confondues, le total s’établit à 10,34 millions, soit une progression de plus de 500 000 emplois en un an ; elle est de 45% sur 5 ans.

La Chine domine à peu près dans tous les domaines, le Brésil (biocarburants) et les USA tirent leur épingle du jeu.

En Europe, l'Allemagne domine. La France, qui n'arrive qu'en troisième position, fait la aussi figure de nain avec 107 000 emplois, soit le tiers de nos voisins d'outre-Rhin. Vraiment pas de quoi donner des leçons.

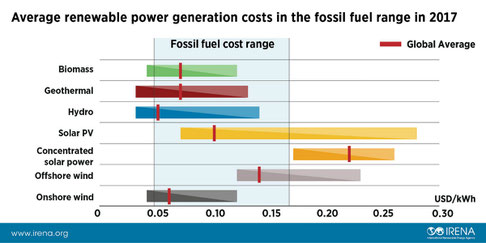

La compétitivité

"Toutes les technologies renouvelables seront compétitives par rapport aux énergies fossiles en 2020", estime l'Agence internationale des énergies renouvelables (IRENA) dans un nouvelle étude sur les coûts des énergies vertes.

Les coûts de l'éolien et du solaire vont encore baisser fortement ces prochaines années au point que ces deux énergies seront globalement moins chères que les énergies fossiles (fuel, gaz, charbon).

Actuellement, les coûts moyens des renouvelables devraient atteindre entre 3 et 10 dollars le mégawattheure (MWh) en fonction des technologies (éolien, solaire, géothermie, biomasse, etc.), quand les énergies fossiles affichent des coûts entre 5 et 17 dollars le MWh, note l'étude. Ils varient en fonction des pays, selon les gisements en énergie ou les réglementations.

Les "meilleurs" projets éoliens terrestre et solaire pourraient ainsi produire une électricité à un coût de 3 dollars par MWh, voire moins dans les deux prochaines années.

A noter qu'actuellement des projets dans la géothermie, la biomasse ou l'hydroélectricité se sont développés avec des coûts inférieurs à 7 dollars le MWh.

Consommation de charbon et climat

Les courbes ci-dessus montrent deux choses :

- avec près de 28% de la consommation totale, le charbon occupe une place de choix parmi les énergies primaires consommées dans le monde.

La tendance n'incite pas à l'optimisme : alors que la consommation mondiale de charbon avait décliné en 2015 et 2016, elle est repartie à la hausse en 2017, d’environ 1 %. Le même résultat est attendu pour 2018.

- ceci est inquiétant car le charbon est l’un des plus importants contributeurs au changement climatique : la production d’électricité à partir de charbon émet 45 % du CO2 rejeté dans l’atmosphère au niveau mondial.

Le graphe de droite indique que pour l'instant nous sommes sur le pire des scenari (courbe orange).

La France a encore quatre centrales à charbon en activité : Cordemais (en cours de reconversion à la biomasse), Le Havre, Meyreuil, Saint-Avold et Carling qui ne produisent que 1,8 % de l'électricité produite en France. Elles sont très polluantes, puisqu'elles rejettent 25 % des émissions de gaz à effet de serre du secteur de l'énergie.

Conclusion

Nul n'ignore que nous sommes dans une économie de marché mondialisée.

Dans ce contexte, la compétitivité sans cesse accrue des EnR devait provoquer l'afflux d'investissements privés. C'est ce que l'on observe, au point que les experts annoncent que dans les deux ans, l'électricité produite par l'éolien terrestre et le solaire coûtera moins cher que celle issue des fossiles. La même tendance est observée pour la géothermie, la biomasse et l'hydroélectricité.

Le développement rapide des EnR s'accompagne évidemment d'une spectaculaire croissance des créations d'emplois qui ne peut que s'accentuer.

Dans pratiquement tous les domaines, la Chine est loin devant, l'Europe (sauf les pays nordiques) est à la traîne et la France très en retard.

La tendance des 18 derniers mois, examinée à la loupe par le journal "Le Monde" du 10 janvier 2019, n'est pas si mauvaise. Cependant elle ne permettra pas à notre pays de rattraper les retards accumulés et d'atteindre l'objectif fixé pour 2020. A noter la grande faiblesse de l'emploi dans les EnR en France, on compte à peine plus de 100 000 emplois (plus de 10 millions dans le monde).

Malheureusement le tableau se noircit si l'on considère l'action publique... d'états qui avaient pris des engagements ferme avec la COP 21, à Paris.

Ainsi, l'investissement public continue de soutenir massivement les énergies fossiles au détriment des EnR ; le ratio est pratiquement de 4 à 1. C'est le cas en France où les derniers événements ne vont pas inciter l'état à ralentir son aide aux grands consommateurs de pétrole ou de gaz !

Autre mauvaise nouvelle pour le climat : la consommation de charbon, grosse émettrice de CO2, qui ne faiblit pas. Notre pays a encore quelques efforts à faire dans ce domaine.

Au vu de ces éléments, la limitation à 2°C de l'augmentation de la température moyenne, depuis le début de l'ère préindustrielle, est loin d'être assurée.

L'utopie n'est donc pas de penser que l'économie mondiale peut basculer très rapidement vers l'utilisation massive d'énergies propres, sans dommage pour l'emploi... mais peut-être de croire que des pays auront le courage de porter au pouvoir des dirigeants capables de réaliser cette nouvelle révolution industrielle.

Si nous voulons que nos enfants, petits-enfants et leurs descendants profitent encore d'une planète VIVANTE...

Si nous réalisons que tout ce qui existe sur cette terre fait partie de la même chaîne solidaire du VIVANT...

Au lieu de nous lamenter, de tout casser... emparons nous des outils démocratiques pour promouvoir à tous les niveaux des femmes et hommes de bonne volonté, capables d'agir pour le bien commun.

Ils existent, nous les connaissons tous, nous les avons vu à l'oeuvre dans l'immense tissus associatif de ce pays.

On peut consulter :

- négaWatt,

Deux sites "engagés" mais sérieux.

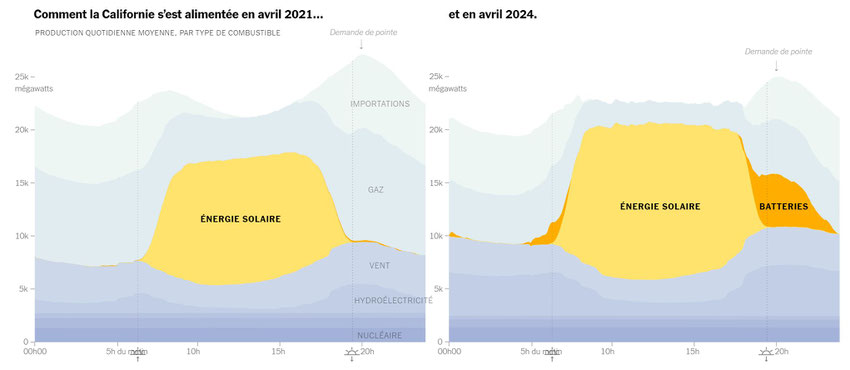

L'énergie de demain ce n'est pas le nucléaire mais le solaire !

La Californie en fait la démonstration

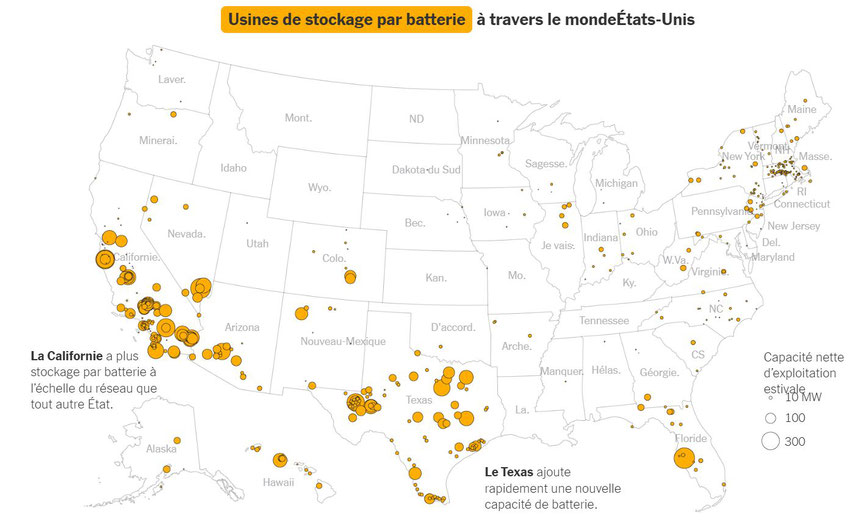

Depuis 2020, la Californie a installé plus de batteries géantes que partout ailleurs dans le monde, à l’exception de la Chine. L’excès d’énergie solaire produite pendant la journée peut être stockée pour une utilisation à la tombée de la nuit.

Les batteries jouent un rôle central dans le réseau électrique californien, remplaçant partiellement les combustibles fossiles le soir.

Entre 19 heures et 22 heures le 30 avril dernier, par exemple, les batteries ont fourni plus d'un cinquième de l'électricité californienne et ont produit, pendant quelques minutes, 7 046 mégawatts d'électricité, soit l'équivalent de la production de sept grands réacteurs nucléaires.

La Californie dispose désormais d' une capacité de batterie de 10 000 mégawatts sur le réseau , suffisamment pour alimenter 10 millions de foyers pendant quelques heures. Les batteries sont « capables de gérer très efficacement la demande du soir où l'énergie solaire diminue et où la demande des clients augmente »

Au cours des trois dernières années, la capacité de stockage des batteries sur les réseaux américains a décuplé, pour atteindre 16 000 mégawatts. Cette année, il devrait encore presque doubler, avec une très forte croissance au Texas, en Californie et en Arizona.

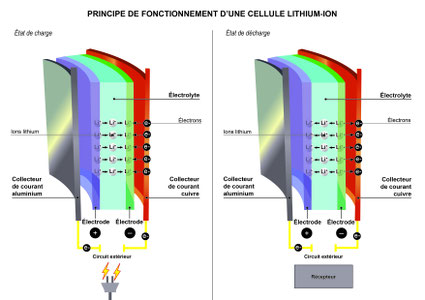

La plupart des batteries des réseaux utilisent la technologie lithium-ion, similaire aux batteries des smartphones ou des voitures électriques. À mesure que l’industrie des véhicules électriques s’est développée au cours de la dernière décennie, les coûts des batteries ont chuté de 80 %, ce qui les rend compétitives pour le stockage d’énergie à grande échelle.

Néanmoins, aujourd'hui, la plupart des batteries proviennent encore de Chine, ce qui rend les opérateurs vulnérables aux différends commerciaux. C'est pourquoi, Le gouvernement américain accorde des prêts considérables (9,2 milliards de dollars pour la construction de trois usines de batteries électriques destinées aux véhicules de Ford) dans le cadre de la politique de réindustrialisation promue par Joe Biden.

En Californie, qui s'est fixé des objectifs ambitieux en matière de lutte contre le changement climatique, les décideurs politiques espèrent que les batteries du réseau pourront aider l'État à obtenir 100 % de son électricité à partir de sources sans carbone d'ici 2045.

En Californie, les batteries semblent réduire les émissions provenant des combustibles fossiles. En avril, la consommation de gaz de l'État est tombée à son plus bas niveau depuis sept ans.

Notre seul dieu : c'est le soleil !

Akhenaton, fils d’Amenhotep III et père de Toutankhamon, a régné sur l'Egypte entre -1355 et -1338. Il est à l'origine d'une révolution religieuse en bannissant les dieux du panthéon traditionnel de l’Egypte de l’époque au profit d’un seul, Aton, le dieu Soleil. Il est considéré par certains comme le premier monothéiste de l’histoire.

Adorer le Soleil n'a rien d'absurde. C'est bien lui qui est au centre de notre système planétaire. A lui seul, il représente 99,86% de la masse du système solaire.

Le potentiel de l'énergie solaire est considérable : la Terre reçoit chaque année plus de 8.000 fois la consommation énergétique mondiale annuelle.

Alors si au lieu de ravager notre sous-sol, nous avions levé les yeux au ciel comme les Egyptiens, les Incas et quelques autres ?

Il aura fallu attendre le début du XXIème siècle pour qu'enfin les hommes comprennent que notre seul dieu, c'est le soleil !

Certes cette énergie est disponible, encore faut-il savoir la recueillir et en particulier la transformer en électricité.

En France, dans le sillage du four solaire d'Odeillo, le CNRS et l'EDF inaugurent en 1983 la centrale électro-solaire THÉMIS à Targasonne (P-O). Elle constitue alors une véritable référence internationale en matière de conversion de l'énergie solaire en électricité..

Hélas, la dégringolade des cours du baril de pétrole porte un cours fatal au projet qui est abandonné dès 1986.

Il faudra attendre près de 20 ans (2004), pour que Thémis Solaire Innovation, centre de recherche et de développement consacré à l'énergie solaire, permette la réhabilitation du site.

Maudit soit cet or noir qui a paralysé les recherches sur l'énergie solaire, mais aussi sur les piles à combustible ou encore la fusion nucléaire.

Mettre le soleil en bouteille !

Un rêve qui va devenir réalité

Domestiquer le soleil, le confiner, le mettre en bouteille... voila une utopie qui surgit déjà au coeur de la révolution industrielle du XIXème siècle.

Depuis la machine à vapeur, mise au point par James Watt en 1769, le charbon est la clé de l'essor industriel (textile, sidérurgie) et des transports.

Mais très vite la crainte de voir s'épuiser les ressources de charbon taraude les esprits. L’économiste britannique Stanley Jevons donne une grande publicité au débat sur l’épuisement de la houille en publiant The Coal Question en 1865. Il note :

" À mesure que les améliorations technologiques augmentent l’efficacité avec laquelle une ressource est employée, la consommation totale de cette ressource augmente au lieu de diminuer, ce qui conduit à s’interroger sur la finitude des ressources disponibles".

Certes le pétrole viendra prendre le relais du charbon, mais pour l'or noir aujourd'hui se pose la même question qu'hier... et s'y ajoute le désastre écologique résultant de la combustion des hydrocarbures.

Voila pourquoi nos regards se sont à nouveau tournés vers le soleil, où de gigantesques réactions thermonucléaires produisent en continu une quantité de chaleur faramineuse (15 millions de degrés au centre de l'astre et 6000°C à la surface).

Cela dure depuis 4,5 milliards d'années et cela continuera encore pendant 6 milliards d'années.

Chaque seconde sur le soleil, les réactions de fusion utilisent 620 millions de tonnes d'hydrogène qui sont transformées en 615,7 millions de tonnes d'hélium... et beaucoup d'énergie, dont une petite partie est reçue par la Terre (l’énergie reçue à chaque seconde, par rayonnement sur une surface de 1 m2 , appelée constante solaire K, est de 1367 W).

Dès l'Antiquité, les hommes ont utilisé l'énergie solaire.

Le système le plus ancien est la parabole solaire, certaines sources affirment qu'on s'en servait pour allumer le feu des jeux olympiques antiques. Archimède (-287/-212) est connu pour avoir mis le feu aux navires de l'armée romaine à Syracuse avec des lentilles concentrant la lumière du Soleil.

La chaleur solaire, qui est à l’origine de la vie et des cycles biologiques et climatiques, n’a jamais cessé d’être exploitée de façon indirecte, mais c’est sous le Second Empire que les premières réalisations mécaniques voient le jour.

Au XIXe siècle, le mythe solaire est omniprésent dans la littérature et l’imaginaire .

Le Français Augustin Mouchot imagine alors des procédés permettant de capter l’énergie solaire à des fins industrielles.

En 1865, il réalise un appareil composé d’un miroir parabolique au foyer duquel une marmite porte l’eau à ébullition en cinq minutes.

Dans le roman, Travail (1901) d'Emile Zola, le narrateur constate également que l’épuisement des mines de charbon est un problème crucial quand la demande en l’électricité croît de façon exponentielle. Et c’est ainsi qu’il imagine la possibilité de capter l’énergie solaire afin d’en faire un « moteur universel ».

Las, la découverte de nouvelles ressources de houille, puis l'avènement du pétrole renvoient dans les limbes les projets de machines à vapeur solaire, dont le rendement est plus que médiocre.

Il aura fallu attendre près d'un siècle, les crises pétrolières... et la pollution, pour que le soleil soit à niveau au centre des débats énergétiques.

J'ai fait le point ICI sur l'avancement des travaux sur l'énergie solaire, photovoltaïque et autres.

Les progrès sont spectaculaires, mais un pas de géant reste à accomplir pour que ces énergies suffisent à combler tous les besoins énergétiques de la planète.

C'est encore le soleil qui nous fournit un modèle pour produire de l'énergie de façon quasi illimitée, avec très peu de matières, grâce à la fusion nucléaire.

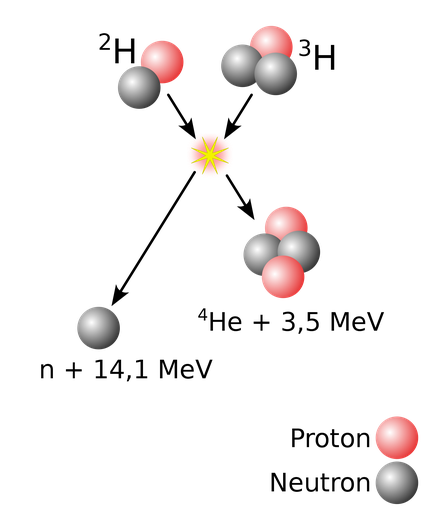

Dans une réaction de fusion la masse du produit étant inférieure à la somme des masses des noyaux fusionnés, la différence (le défaut de masse) est transformée en énergie cinétique (puis en chaleur) selon la fameuse formule d'Einstein E = m c2.

La quantité d’énergie libérée par unité de masse est colossale.

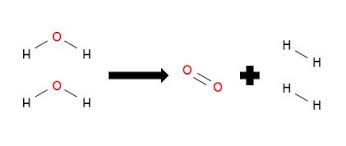

Dans le cas d'un combustible deutérium/tritium (réaction ci-contre), la fusion consiste à rapprocher les deux atomes d’hydrogène (deutérium et tritium) à des températures de plusieurs millions de degrés, comme dans le Soleil et la plupart des étoiles de l'Univers, pour créer un noyau plus lourd (le contraire de la fission en quelque sorte).

Lorsque ces noyaux légers fusionnent, le noyau créé se retrouve dans un état instable. Il tente de retrouver un état stable en éjectant un atome d’hélium et un neutron et crée alors de l’énergie. Il s'agit d'une réaction propre : les produits de la fusion eux-mêmes ne sont pas radioactifs

A masse égale, la fusion d'atomes légers libère une énergie près de quatre millions de fois supérieure à celle d'une réaction chimique telle que la combustion du charbon, du pétrole ou du gaz, et quatre fois supérieure à celle des réactions de fission nucléaire.

Malheureusement il y a loin de la coupe aux lèvres ; la mise en oeuvre de ce véritable "soleil en bouteille" (en cuve !) se heurte à des défis technologiques considérables.

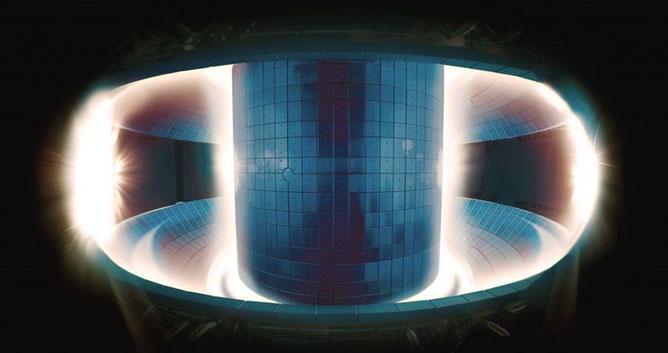

En effet, il faut porter le carburant à l'état de plasma, ce qui nécessite des températures de l'ordre de 150 millions de degrés. Evidemment aucun matériau ne résiste à une telle température. Les chercheurs travaillent donc principalement sur le « confinement magnétique » qui revient à maîtriser, à très haute température, un plasma confiné dans une boîte immatérielle en forme d'anneau, créée par des champs magnétiques de très haute intensité.

Attention : ne pas confondre température et chaleur ! Par exemple, un tube fluorescent contenant un gaz (néon, argon, vapeur de mercure...) excité par une décharge électrique. Au sein du tube, la température du gaz est très élevée, de l'ordre de 10 à 15 000 degrés. Or, au toucher, un « néon » est presque froid.

Ce paradoxe s'explique par la très faible densité du gaz contenu dans le tube fluorescent. Pour transmettre de la chaleur d'un milieu vers un autre, il faut de la densité et plus celle-ci est élevée, plus grande sera la quantité de chaleur transférée.

Or le plasma est un milieu très ténu ; c'est un quasi-vide, un million de fois moins dense que l'air que nous respirons.

Jusqu'ici il n'a jamais été possible d'obtenir des champs magnétiques nécessaires pour que les réactions de fusion produisent autant d'énergie qu'elles en consomment (Q = 1, c'est le breakeven). Le record actuel est détenu par le JET, plus grand tokamak existant situé au Royaume-Uni, qui est parvenu à restituer sous forme d'énergie environ 67 % de la puissance qui lui avait été apportée (Q= 0,67).

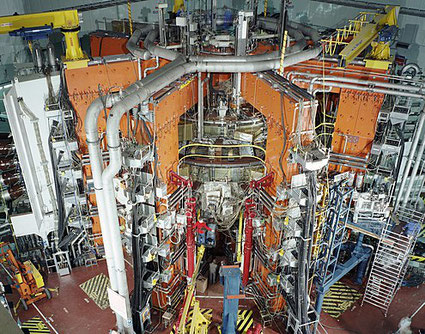

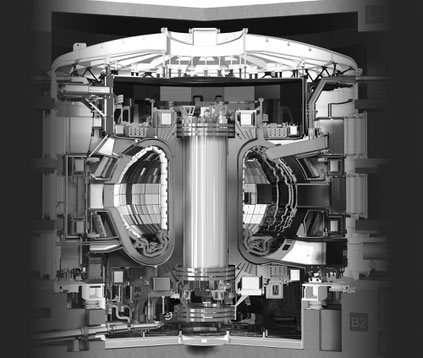

Le tokamak

La première percée technologique majeure dans le domaine de la fusion nucléaire remonte à 1968.

Elle fut l'oeuvre de chercheurs russes, dont Andreï Sakharov, qui parvinrent à atteindre des niveaux de température et des temps de confinement du plasma — deux des paramètres essentiels de la fusion — jamais obtenus par le passé.

La machine soviétique consistait en un dispositif de confinement magnétique en forme d'anneau baptisé tokamak.

Un tokamak est une machine capable de créer et confiner un plasma chaud à près de 150 millions de degrés dans une cage magnétique en forme d’anneau. C’est en quelque sorte un four qui permet de créer un plasma et de le maintenir en son cœur grâce à des champs magnétiques très puissants.

Le tokamak (toroïdalnaïa kameras magnitnymi katushkami en russe) s'imposa dès lors comme le concept dominant parmi les chercheurs qui travaillaient sur la fusion, et les machines se multiplièrent dans la plupart des pays développés.

En 1991, le tokamak du JET a réalisé une première mondiale en produisant de l'énergie de fusion de manière contrôlée.

Le tokamak Tore Supra du centre de recherche nucléaire de Cadarache détient le record de durée d'un plasma (6 minutes et 30 secondes).

ITER et la fusion nucléaire

Trente-cinq pays (la Chine, l'Union européenne, l'Inde, le Japon, la Corée, la Russie et les États-Unis) se sont engagés dans une collaboration de trente-cinq ans pour construire et exploiter l'installation expérimentale ITER (International Thermonuclear Experimental Reactor), une machine qui doit démontrer que la fusion peut être utilisée comme source d'énergie à grande échelle, non émettrice de CO2, pour produire de l'électricité.

Le tokamak d'ITER sera la plus grande installation de ce type au monde, avec un grand rayon de plasma de 6,2 m et un volume de plasma de 840 m³.

En juin prochain, le Joint European Torus (JET) commencera ses essais de fusion avec des quantités égales de deux isotopes de l'hydrogène : le tritium et le deutérium.

C'est ce mélange de carburant qu'ITER utilisera pour tenter de faire diverger une réaction de fusion, c'est à dire produire plus d'énergie qu'il n'en est nécessaire pour provoquer cette réaction nucléaire.

Avec ITER, le record de puissance de fusion produite par le tokamak européen JET devrait être pulvérisé. Le ratio de 0,67 devrait être porté à 10 par ITER — 500 MW de puissance de fusion pour une puissance en entrée de 50 MW.

Le chantier ITER, implanté sur un terrain de 180 hectares situé à Cadarache (Saint-Paul-lez-Durance), est colossal. Les quatre premières années ont été consacrées à la seule réalisation d'une fosse sismique.

Au cours de ces quatre années, une fosse sismique (130 mètres de long, 90 de large et d'une profondeur de 17 mètres) a été aménagée, des murs

de soutènement, et un premier radier ont été créés. C'est sur ce premier radier qu'est solidement ancré le dispositif parasismique qui permettra, en cas d'événement sismique, d'isoler du sol les

bâtiments et les équipements du Complexe tokamak.

Quelque 493 colonnes de béton sont positionnées à intervalle régulier sur le radier. Chacune des colonnes porte un plot parasismique de vingt centimètres d'épaisseur, constitués d'une alternance de six couches de caoutchouc et de plaques d'acier. La structure flexible de ces « sandwiches » permettra de filtrer et d'absorber les accélérations associées aux mouvements du sol (l'amplitude latérale de déplacement des couches du « sandwich » est de l'ordre de 10 cm).

La phase d'assemblage de la machine a démarré en juin 2020. Un premier plasma devrait être produit en 2025.

Vers 2035, ce réacteur expérimental devrait laisser la place à un ensemble beaucoup plus abouti, capable de produire de l'électricité.

A noter qu'il subsiste des points d'ombre sur la physique des plasmas... qui pourraient perturber le calendrier !

On peut raisonnablement envisager une production d'électricité en continu par un fusion nucléaire vers 2050. Dans les années 60, on évoquait cet aboutissement pour la fin du XXème siècle !

Mais il faudra probablement attendre la fin du XXIème siècle pour que de l'électricité "thermonucléaire" soit véritablement commercialisée.

Nos descendants auront alors réalisé le rêve des utopistes du XIXème siècle ; ils auront mis le soleil en bouteille !

Le photovoltaïque (PV)... enfin !

"L'énergie solaire a le potentiel de jouer un rôle central dans le futur système énergétique mondial en raison de l'ampleur de la ressource solaire, de sa prévisibilité et de son caractère omniprésent. La capacité solaire photovoltaïque (PV) installée dans le monde dépassait 500 GW à la fin de 2018 et une capacité PV supplémentaire estimée à 500 GW devrait être installée d'ici 2022-2023, ce qui nous amène à l'ère de la photovoltaïque à l'échelle TW [térawatt : 1TW = 1000 gigawatts]. Compte tenu de la rapidité avec laquelle l'industrie photovoltaïque évolue, à la fois en termes de baisse spectaculaire des coûts et d'augmentations à l'échelle de l'industrie manufacturière, de nombreux observateurs [ont révisé à la hausse leurs prévisions]... Nous envisageons un avenir avec 10 TW de systèmes photovoltaïques d'ici 2030 et entre 30 et 70 TW d'ici 2050, fournissant la majorité de l'énergie mondiale "

Science, 31 mai 2019 : vol. 364, numéro 6443, p. 836-838

Ce texte est l'introduction d'un article très récemment paru dans la grande revue scientifique américaine Science. Il est signé par une cinquantaine de spécialistes de haut niveau appartenant à 27 Instituts prestigieux d'une dizaine de pays (USA, Allemagne, Japon, Suisse, Finlande... la France est absente).

Autant dire qu'il est à prendre très au sérieux !

Rappel - Bien qu'ancienne, la technologie utilisant les cellules au silicium cristallin, avec pour l'élément actif le silicium dopé dans la masse, représente encore 90 % des parts de marché, du fait de sa robustesse et de ses performances (son rendement peut approcher les 20 % pour une durée de vie de 30 ans environ), mais aussi des investissements importants qui lui ont été consacrés.

Les prix baissent, les projets se multiplient

Le graphique ci-contre est éloquent.

A la fin de 2018, avec seulement 500 GW de PV installés, le prix de vente moyen mondial des modules était déjà inférieur à 0,25 USD / W. La baisse des coûts au niveau des systèmes photovoltaïques s'est traduite par une baisse spectaculaire du prix de l'électricité générée par les centrales photovoltaïques par rapport aux autres formes de production.

Les prix de l'électricité, dominés par les combustibles fossiles et la production nucléaire, sont restés relativement stables au Japon, en Allemagne et aux États-Unis pendant une longue période (voir le premier graphique). En revanche, les prix des systèmes photovoltaïques ont fortement diminué.

Nous entrons dans une ère où le photovoltaïque est déjà concurrentiel par rapport à la production d'électricité conventionnelle dans de nombreuses régions du monde.

En Allemagne, la capacité d'électricité renouvelable variable (éolienne et solaire) est passée de 45 à 98 GW de 2010 à 2016, ce qui s'est traduit par une augmentation de la pénétration du réseau de 8% à près de 20% (en France le solaire plus l'éolien représentaient 7% en 2018).

Aujourd'hui, de plus en plus de recherches concluent que la décarbonisation de l’électricité suivie de l’électrification de presque toutes les parties du système énergétique est la voie la moins coûteuse pour un système d’énergie durable à faibles émissions de carbone.

La montée en puissance des installations

Jusque-là dominée par une myriade de petits projets, l'énergie solaire voit naître des centrales géantes -- des centaines de mégawatts, bientôt au-delà du gigawatt-- grâce à la baisse des prix et à la confiance croissante des investisseurs.

En France les grands projets se multiplient. La centrale solaire de Toul-Rosières a été inaugurée en 2012. D’une puissance de 115 mégawatts-crêtes, cette centrale est dotée de 1, 4 millions de panneaux photovoltaïques de 120X60 cm, couvrant une superficie de 120 hectares, capables d’alimenter plus de 55.000 personnes en consommation électrique, chauffage compris.

Des installations plus modestes voient le jour sur des ombrières de parking. Par exemple à Quincieux, au nord de Lyon, une installation de plus de 15 000 panneaux photovoltaïques sur la toiture de 13 ombrières de parking produira, dès la fin de cette année 3955 MWh d’électricité verte, soit l’équivalent du double de la consommation de la population de Quincieux (3500 habitants).

Située en Californie, la ferme solaire Topaz de 550 mégawatts produit suffisamment d'électricité pour alimenter 160 000 foyers californiens moyens. Le site de Topaz a été choisi après un examen approfondi tenant compte de la ressource solaire disponible, de la proximité des lignes de transport d'électricité existantes, des utilisations actuelles du sol et des sensibilités environnementales.

Les problèmes à résoudre

Nouveaux matériaux pour les cellules solaires

Le poids, la rigidité et le coût, sont les inconvénients importants des cellules solaires au silicium.

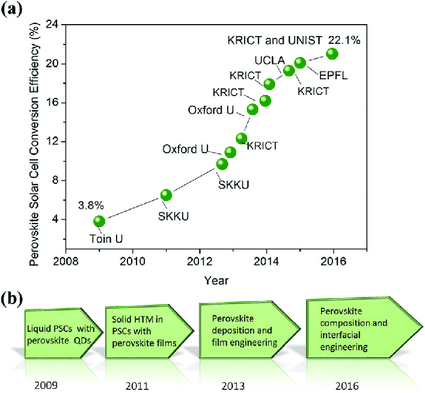

Depuis 10 ans, les cellules solaires pérovskites (PSC) suscitent un vif intérêt en raison de leurs propriétés uniques : une efficacité de conversion de l'énergie (PCE) exceptionnelle, un faible coût (moitié moins cher que les cellules actuelles au silicium) et une facilité de traitement à grande échelle. Elles sont de plus extrêmement légères et peuvent être fabriquées avec des substrats en plastique flexibles.

Les péroskites ont enfin pour avantage de pouvoir se placer partout grâce à leur souplesse et de prendre de multiples teintes.

L’efficacité des cellules solaires de dispositifs utilisant ces matériaux est passée de 3,8% en 2009 à 25,2% en 2019, dans les architectures à simple jonction et à 28% dans les cellules tandem à base de silicium, dépassant ainsi les efficacité maximale obtenue dans les cellules solaires au silicium.

Cependant il reste à régler d'importants problèmes de stabilité : vis à vis de l'humidité, de l'oxygène, des UV. Malgré tout, et au vu des investissements réalisés -tant publics que privés - nul doute que ces problèmes seront résolus à court terme.

Dès 2020, à Wroclaw, en Pologne, une usine fabriquera 180 000 m2 de panneaux solaires en pérovskites. Une production qui devrait ensuite augmenter, tant la demande risque d’être exponentielle.

Le stockage de l'énergie

C'est actuellement le défaut de la cuirasse : le développement du PV implique des capacités de stockage considérablement accrue.

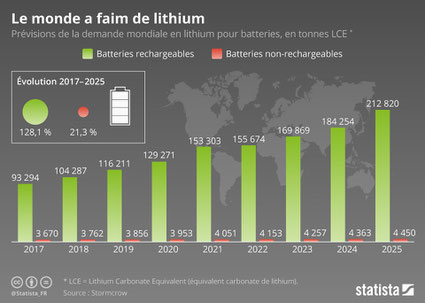

Actuellement, les batteries au lithium constituent la principale solution de stockage. Mais la production mondiale de ce métal rare, à l'extraction polluante et coûteuse, est limitée à 40 000 tonnes par an. Avec la croissance rapide des véhicules électriques, il en faudra de trois à sept fois plus dans les vingt-cinq prochaines années, selon l'Ademe.

Actuellement, des batteries au lithium de fortes capacités ont été développées, notamment par Tesla en Australie ( 129 MWh). Et le process s'avère éminemment rentable !

Cependant de nouvelles technologies sont en développement ou même en cours de mises en oeuvre.

Par exemple, Hydrogène de France (HDF Energy) va construire en Guyane la plus grosse centrale du monde de production et stockage d'électricité renouvelable. Son parc de panneaux photovoltaïques de 55 MW sera couplé avec une capacité de stockage de 120 MWh à base d'hydrogène, plus un stockage d'appoint par batteries lithium-ion de 20 MWh. Soit 140 MWh.

"L'alliance de deux technologies de stockage permet de profiter des avantages de chacune,. L'hydrogène stocke l'énergie sur de longues périodes, tandis que les batteries sont capables de restituer l'électricité très rapidement, dans la milliseconde. L'électricité solaire sert à hydrolyser de l'eau, produisant de l'hydrogène (et de l'oxygène), stocké sous forme de gaz comprimé dans de grands conteneurs de 12 mètres de long. L'opération inverse produit de l'électricité dans une pile à combustibles. Ainsi, la centrale ne rejettera que de l'oxygène et de la vapeur d'eau."

Sylvain Charrier, directeur du développement de HDF pour l'Outre-mer

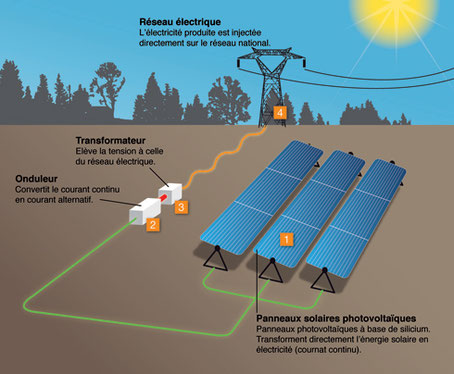

Les onduleurs

Les systèmes photovoltaïques produisent un courant continu, ils doivent donc se connecter au réseau via des onduleurs, qui se synchronisent généralement sur la fréquence nominale de ce réseau pour exporter de l'énergie.

Les nouvelles installations d'onduleurs photovoltaïques doivent assurer la fiabilité du réseau ( régulation de la tension et de la fréquence).

À des niveaux très élevés de déploiement, les systèmes PV devront générer leurs propres formes d'onde de référence de tension et se synchroniser ensemble. De nouvelles techniques telles que les contrôleurs d'oscillation virtuels sont en cours de développement, ils sont capables de générer des temps de réponse rapides et de créer des systèmes à inertie nulle.

L'énergie solaire thermodynamique

Les centrales solaires thermodynamiques constituent un moyen de résoudre le problème du stockage.

Elles concentrent le rayonnement solaire pour produire de la chaleur à très haute température, puis de l’électricité.

Dans les centrales à tour comme celle d'Ivanpah (Californie), des centaines ou des milliers de miroirs placés au sol, appelés héliostats, orientent les rayons solaires vers le sommet d’une tour, qui peut dépasser 200 mètres de haut. Les héliostats sont orientables afin de suivre la course du soleil tout au long de la journée. En haut de la tour, un absorbeur, où circule le fluide caloporteur (généralement des sels fondus), transforme le rayonnement en chaleur à haute température. Ces centrales nécessitent un fort ensoleillement et une grande surface au sol.

On trouve aussi des centrales à collecteurs cylindro-paraboliques comme Noor au Maroc (160 MW, 500 000 miroirs, 4,8 km2), les centrales à miroirs de Fresnel telle eLLo à Llo (P-O) (9 MW).

Le coût de l'électricité obtenu par ce moyen est encore élevé, mais il a l'immense mérite de régler le problème du stockage qui se pose avec le photovoltaïque.

Nous ne sommes qu'au début de l'exploitation de ces technologies, mais des projets gigantesques sont en cours un peu partout dans le monde, en Israël, au Chili, en Australie, aux USA, en Espagne...

La centrale solaire thermodynamique d'Ivanpah est capable de délivrer 550 megawatts (MW) de puissance. Elle fournit suffisamment d'électricité pour alimenter quelque 160 000 foyers.

Elle occupe une surface de 25 kilomètres carrés et se compose de neuf millions de panneaux solaires surélevés de seulement 1,7 mètre, ce qui limite l'atteinte au paysage.

Hydrogène vert : on avance !

Jupiter 1000

À Fos-sur-Mer (Bouches-du-Rhône), le démonstrateur Jupiter 1000 a injecté le 20 février de l’hydrogène pour la première fois sur le réseau gazier. Une étape importante pour ce projet de type « Power to Gas ».

Il s'agit de produire de l'hydrogène par électrolyse de l'eau à partir d'électricité verte (éoliennes, solaire).

L'hydrogène devrait prendre une place importante au sein des énergies du futur, mais aussi avoir un rôle essentiel au niveau du stockage de l'électricité "verte".

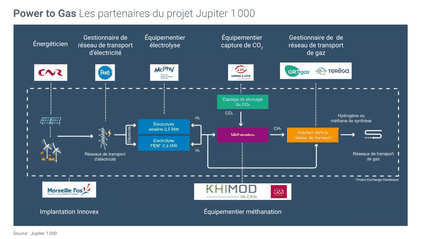

Le projet Jupiter 1000 réunit 9 partenaires : le Port de Marseille Fos qui accueille le démonstrateur, la CNR, Compagnie Nationale du Rhône, premier producteur français d'énergie uniquement renouvelable, McPhy qui a construit les électrolyseurs pour générer l’hydrogène (1 MW de puissance avec 2 technologies d’électrolyse testées : alcaline et P.E.M., Leroux & Lotz qui doit capter du CO2 dans des fumées industrielles pour le fournir à l’installation de méthanation, Khimod qui réalise les réacteurs échangeurs de méthanation avec le CEA et les gestionnaires de réseaux gaziers et électrique.

On peut dire que le fleuron des entreprises innovantes dans le domaine est réuni autour du démonstrateur Jupiter 1000.

Sur le site de Fos-sur-Mer, la production d’hydrogène a commencé en novembre 2019 et la première injection d’hydrogène dans le réseau gazier a été réalisée le 20 février 2020. Il est prévu de mettre en service la brique de méthanation de Jupiter 1 000 « au 2e semestre 2020 ».

Le Plan hydrogène français

Ce plan a été présenté le 1ier juin 2018 par Nicolas Hulot (alors ministre), qui soulignait alors que l’hydrogène offrait des atouts énergétiques indispensables à la transition écologique :

Stockage : l’hydrogène peut être produit par électrolyse à partir d’eau et d’électricité, et ensuite être stocké ce qui permet donc de stocker l’électricité sous forme de gaz ;

Electricité : en l’utilisant dans une pile à combustible, l’hydrogène se transforme en électricité et en eau, ce qui permet de l’utiliser comme un carburant propre pour les voitures sans émission de polluants ni de CO2 ;

Gaz vert : il peut être injecté dans le réseau de gaz, mélangé au méthane ;

Captage du CO2 : l’hydrogène peut se coupler au CO2 pour fabriquer du méthane de synthèse, qui peut être utilisé comme du gaz normal : il permet donc d’utiliser le gaz carbonique qui s’échappe de certaines usines et de le réutiliser dans les réseaux de gaz .

Notons qu'en plus que l'hydrogène affiche un excellent rapport énergétique : à masse égale, il produit quatre fois plus d’énergie que le pétrole ou le gaz naturel.

L’Agence internationale de l’énergie (AIE) publiait un an plus tard (le 14 juin 2019), un rapport consacré aux perspectives de développement de l’hydrogène « propre » dans le monde.

Il appelait à étendre les usages de ce vecteur énergétique dont les coûts de production devraient être réduits.

La fourniture mondiale d’hydrogène à l’industrie a plus que triplé depuis 1975 et avoisine actuellement 70 millions de tonnes par an.

Cet hydrogène est aujourd’hui quasiment intégralement produit à partir de gaz naturel et de charbon (dans une moindre mesure), ce qui entraîne chaque année l’émission de près de 830 millions de tonnes de CO2.

L’AIE estime que l’hydrogène pourrait « contribuer à un futur énergétique durable et résilient », en se déployant au détriment des combustibles fossiles dans de nombreux secteurs où il est actuellement « presque totalement absent, comme le transport, les bâtiments et la production électrique ».

Jupiter 1000 se situe exactement dans le cadre de ces objectifs.

LIRE l'analyse du rapport de l’IRENA , Hydrogène : un allié à venir pour la production d’électricité renouvelable

Jupiter 1000 : Power to gas

En effet, ce projet est doublement vertueux.

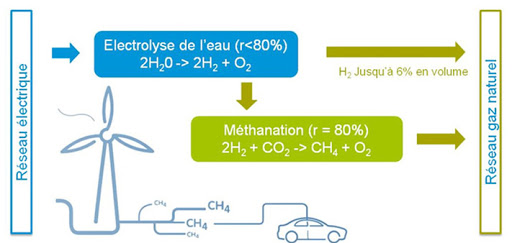

Le « Power to Gas » consiste d'abord à transformer de l’électricité en hydrogène par électrolyse de l’eau (en utilisant l’électricité pour transformer les molécules d’eau en hydrogène et en oxygène).

Cela permet entre autres de valoriser les surplus de production électrique émanant d’installations renouvelables intermittentes et d’offrir ainsi une solution de flexibilité au réseau.

L’hydrogène produit peut ensuite être combiné, par un processus de méthanation, à du dioxyde de carbone pour obtenir du méthane de synthèse. Ce procédé « permet de recycler du CO2, préalablement capté au sein des fumées industrielles ou d’un site de production de biométhane.

McPhy, l'innovation à la française

McPhy est une société dromoise spécialisée dans l'électrolyse de l'eau.

Cette entreprise de pointe a annoncé qu'il allait équiper la plus grande unité de production d’hydrogène zéro-carbone en Europe , un projet initié par deux sociétés néerlandaises Nouryon (chimie de spécialité) et Gasunie (infrastructure et de transport de gaz naturel) et qui sera installé à Delfzijl , aux Pays-Bas.

En effet la technologie innovante d’électrolyse alcaline "Augmented McLyzer" de McPhy a été choisie pour être la pierre angulaire de ce projet industriel majeur .

C'est "la première unité de production d’hydrogène zéro-carbone de cette envergure à être développée en Europe, avec une capacité de 3.000 tonnes par an (20 MW).

A noter que McPhy travaille aussi sur les piles à hydrogène réversible (PEM, voir ci-dessous).

Stocker l'électricité "verte" grâce à l'hydrogène

Actuellement, les batteries au lithium constituent la principale solution de stockage. Mais la production mondiale de ce métal rare, à l'extraction polluante et coûteuse, est limitée à 40 000 tonnes par an.

Cependant de nouvelles technologies sont en développement ou même en cours de mises en oeuvre.

Le stockage de l'électricité via l'hydrogène notamment qui se déroule en deux phases :

1 - L’électrolyse : passage de l’électricité à l’hydrogène,

2 - La pile à combustible (PAC) : passage de l’hydrogène à l’électricité.

Par exemple, Hydrogène de France (HDF Energy) va construire en Guyane la plus grosse centrale du monde de production et stockage d'électricité renouvelable. Son parc de panneaux photovoltaïques de 55 MW sera couplé avec une capacité de stockage de 120 MWh à base d'hydrogène, plus un stockage d'appoint par batteries lithium-ion de 20 MWh. Soit 140 MWh.

"L'alliance de deux technologies de stockage permet de profiter des avantages de chacune,. L'hydrogène stocke l'énergie sur de longues périodes, tandis que les batteries sont capables de restituer l'électricité très rapidement, dans la milliseconde. L'électricité solaire sert à hydrolyser de l'eau, produisant de l'hydrogène (et de l'oxygène), stocké sous forme de gaz comprimé dans de grands conteneurs de 12 mètres de long. L'opération inverse produit de l'électricité dans une pile à combustibles. Ainsi, la centrale ne rejettera que de l'oxygène et de la vapeur d'eau."

Sylvain Charrier, directeur du développement de HDF pour l'Outre-mer

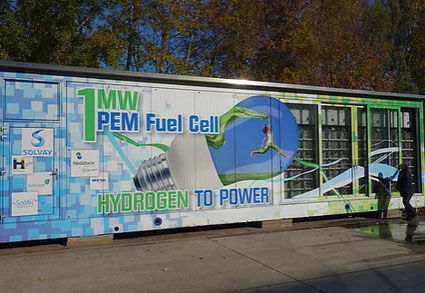

Le développement de cette filière passe par l'optimisation des piles à combustible à hydrogène.

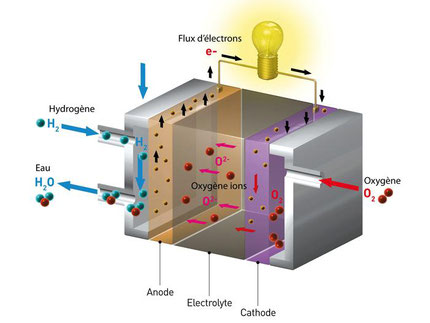

Les piles à combustible

Le principe de la pile à combustible n’est pas nouveau, il a été mis en évidence il y a plus de 150 ans par deux chercheurs, Christian Friedrich Schönbein et Sir William Grove.

Il repose sur une réaction chimique simple :

Hydrogène + Oxygène → Electricité + Eau + Chaleur

2 H2 + O2 → 2 H2O

Cependant le coût de la production d'électricité via les piles à hydrogène est encore trop élevé.

L’amélioration du rapport prix/performance de la pile à hydrogène fait donc l'objet de nombreux travaux, notamment sur l’électrolyte solide (l'échangeur de protons), matière où transitent les ions hydrogènes.

Ainsi, des chercheurs français du CNRS (ESCPI Paris et Université de Montpellier), ont mis au point récemment un matériau de type MOF (Metal Organic Framwork) préparé à partir d'acide α-aminé naturel, montrant une conductivité protonique élevée et stable.

Les piles à hydrogène réversibles

D'un autre côté, de nombreux groupes de recherche et développement travaillent sur des piles à hydrogène réversibles pouvant, soit produire de l'hydrogène à partir d'électricité, soit produire de l'électricité à partir d'hydrogène.

Ces piles sont basées à la fois sur des technologies de piles à combustible à membrane échangeuse de protons et de piles à combustible à oxyde solide

Récemment, une cellule électrochimique réversible en céramique protonique très performante a été mis au point.

LE CEA et la start-up Sylfen se sont vu décerner le prix EARTO, qui récompense les meilleures innovations de l’année. L’objet du prix, le Smart Energy Hub, est un système hybride de stockage et de cogénération d’énergie : il peut fonctionner en mode « électrolyse » pour stocker de l’énergie renouvelable sous forme d’hydrogène, ou en mode « pile à combustible » pour produire de l’électricité et de la chaleur à partir d’hydrogène précédemment produit ou de méthane.

L'éolien accélère avec les turbines offshore géantes

A l'embouchure du port de Rotterdam se trouve le prototype d'une éolienne géante produite par la General Electric : Haliade-X.

Ces turbines, capables de produire autant de poussée que les quatre moteurs d'un Boeing 747, selon GE, seront déployées en mer à partir de 2022.

Elle dispose de pales de 107 m de long, le diamètre de braquage de son rotor est plus long que deux terrains de football américain bout à bout et elle culmine à 248 mètre de haut (en bout de pales), soit environ 5 fois la taille de l'Arc de Triomphe.

Les modèles ultérieurs seront plus hauts que n'importe quel bâtiment sur le continent de l'Europe occidentale !

Pour fabriquer une lame d'une longueur aussi extraordinaire qui ne se déforme pas sous son propre poids, GE a fait appel aux concepteurs de LM Wind Power, un fabricant de lames au Danemark (et bientôt en France) que la société a acheté en 2016 pour 1,7 milliard de dollars. Parmi leurs innovations: un matériau alliant fibre de carbone et fibre de verre à la fois léger mais solide et flexible.

En tests depuis novembre 2019 à Rotterdam, l’Haliade-X a été optimisée et sa puissance portée à 13 MW, ce qui correspond à 30 fois la puissance des premières machines danoises, au début des années 90.

Elle a récemment « établi un nouveau record mondial, en produisant 288 MWh en une seule journée ». Cela correspond à un facteur de charge de… 92,3% !

Alors que les facteurs de charge (fonctionnement à pleine puissance) moyens des parcs éoliens dans le monde en 2019 étaient estimés par le GWEC (Global Wind Energy Council) à 23% pour les installations terrestres et à 40% pour celles implantées en mer, General Electric a l'ambition de faire de l'Haliade-X, l'éolienne « la plus efficace au monde » et évoquait fin 2019 un facteur de charge potentiel de 63% pour son modèle, « dans des conditions de vents d’un site allemand typique en mer du Nord ».

A elle seule, Haliade-X peut éclairer une ville de 12 000 foyers. Assemblées en réseau, ces éoliennes pourront alimenter de grandes agglomérations !

Il faut savoir que GE qui n'est venu à l'éolien offshore que grâce à l'acquisition de l'activité électrique d'Alstom en France, en 2015, propose d'entrée une machine deux fois plus puissante que la concurrence (Siemens Gamesa et Vestas Wind Systems, le constructeur de turbines basé au Danemark).

L'unité commerciale, appelée GE Renewable Energy, a consacré 400 millions de dollars à la conception, au recrutement d'ingénieurs et au réoutillage des usines de Saint-Nazaire et de Cherbourg. Le début de la production est annoncé pour le troisième trimestre 2021.

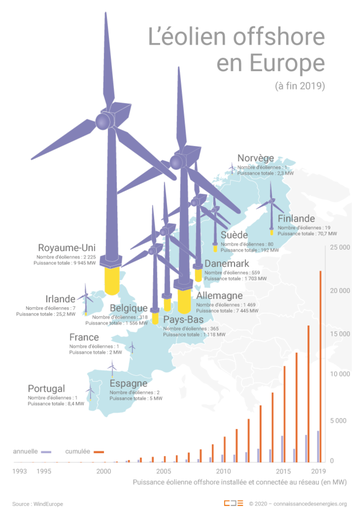

Le parc éolien offshore s'étoffe... mais pas en France !

Bien que les turbines offshore ne représentent actuellement qu'environ 5% de la capacité de production de l'ensemble de l'industrie éolienne, cette partie de l'activité devrait croître plus rapidement dans les années à venir que l'éolien terrestre.

La technologie offshore a pris racine en Europe du Nord depuis les années 80 et se propage maintenant sur la côte est des États-Unis ainsi qu'en Asie.

Les projets de grande envergure, qui coûtent des milliards de dollars, attirent de grands investisseurs, y compris des sociétés pétrolières comme BP , Royal Dutch Shell et Total (avec le rachat de Global Wind Power), qui souhaitent améliorer rapidement leurs offres d'énergie verte. Les investissements en capital dans l'éolien offshore ont plus que triplé au cours de la dernière décennie pour atteindre 26 milliards de dollars, selon l'Agence internationale de l'énergie.

Près de 190 éoliennes Haliade-X devraient constituer le projet éolien Dogger Bank A et B dans les eaux britanniques. À sa mise en service envisagée en 2023, ce parc devrait être le plus « puissant » au monde.

L’Haliade-X a par ailleurs également été sélectionnée pour équiper deux autres projets éoliens offshore aux États-Unis : Skipjack au large du Maryland (120 MW) et Ocean Wind (1 100 MW) au large des côtes du New Jersey, réalisé par Orsted, une société danoise qui est le plus grand développeur de parcs éoliens offshore au monde.

Actuellement c'est l’éolienne V164 de MHI Vestas, d’une capacité de 8,4 MW, qui est le modèle le plus puissant déployé dans les eaux européennes. La puissance unitaire moyenne des éoliennes offshore installées en Europe était en 2019 de 7,8 MW. Depuis 2014, la puissance moyenne par éolienne en mer augmente en moyenne de 16% par an selon WindEurope.

Sur l'illustration ci-dessus, on constate que la France a le bonnet d'âne dans ce domaine important des énergies renouvelables. Elle va fabriquer des éoliennes... pour les autres.

Nos gouvernants - tellement peureux - ne veulent pas faire de... vagues !

Il est vrai que le vent fait du bruit, que les turbines gâchent le paysage et font tourner le lait.

On sait aussi que les panneaux solaires, c'est moche, que la biomasse ça pue, que le nucléaire c'est dangereux, que les barrages ça inonde...

Tous ces râleurs, devraient aller en stage dans les mines de charbon de Silésie ou de Chine.

Ou alors se priver de télé, de portables, d'internet, d'eau chaude, de transports... cela permettrait d'économiser de l'énergie.

Mais en France on veut le beurre, l'argent du beurre et la crémière !

C'est parfois démoralisant d'être Français !

Lithium, après l'or noir, l'or blanc ?

Le lithium a joué un rôle fondamental dans le développement des batteries de hautes performances appelées Lithium-ion (Li-ion).

Les batteries Li-ion présentent actuellement la plus grande capacité d’accumulation d’énergie par unité de masse. Elle peut stocker 3 à 4 fois plus d'énergie par unité de masse que les autres technologies de batteries.

De plus son auto-décharge est faible.

Cet usage représente désormais plus de 50% de la demande mondiale en lithium et en est le moteur principal.

Aujourd’hui, le principal secteur tirant la vente de ces batteries est la production de véhicules électriques.

La consommation totale de lithium pour cet usage est passée d’une part de marché de 20% en 2008 (soit 4 260 t Li) à près de 58% en 2018. Selon les prévisions, cette part pourrait passer à 85% en 2030, voire 2025. Les estimations sur les tonnages de lithium nécessaires à cette échéance varient selon les analyses, ils dépasseront très probablement 150 kt Li en 2025, et atteindre 300 kt Li en 2030.

Les ressources en lithium

Alors que la demande en lithium augmente fortement, depuis 2018, les prix baissent !

En effet, les réserves de lithium mondiales ont été multipliées par 4 entre 2005 et 2017, en réponse au déploiement massif de la technologie des batteries Li-ion.

Plus on consomme de lithium, plus on en cherche et plus on en trouve !

Selon les experts, le risque de pénurie, d'un point de vue géologique, paraît donc limité.

Dans l'industrie, le lithium se produit, s'échange et s'emploie sous forme de carbonate de lithium (Li2CO3) et d'hydroxyde de lithium (LiOH), produits à partir de deux types de sources lithinifères :

- les saumures, tels que les salars d'Amérique du Sud situés dans le « triangle du lithium », partagés entre l'Argentine, le Chili et la Bolivie,

- les minéraux lithinifères issus des pegmatites, greisens et coupoles de granites à métaux rares, tels que les mines de Greenbushes en Australie.

Les principales ressources se situent donc en Australie, qui est devenue le plus gros producteur mondial de lithium (55%), en Amérique du Sud et en Chine (10%). 59 % des réserves identifiées sont en Amérique du Sud - principalement au Chili -, en Chine, en Australie et aux Etats-Unis.

Mais c'est au Mexique que le plus grand gisement de lithium au monde - un salar - a été identifié.

Cette mine de lithium (sous forme de carbonate, LCE) à ciel ouvert, est située dans le désert de Sonora à 170 km de la frontière américano-mexicaine. Avec 243,8 millions de tonnes de réserves prouvées ou potentielles, il s'agit du plus important gisement de lithium au monde.

L'Europe est malheureusement bien moins pourvue, alors qu'elle se lance dans un plan ambitieux de développement des véhicules électriques.

En Europe, les déplacements en voiture représentent environ 12% de toutes les émissions de carbone du continent. Pour rester conforme à l'accord de Paris, les émissions des voitures et des camionnettes devront baisser de plus d'un tiers (37,5%) d'ici 2030. L'UE s'est fixé un objectif ambitieux de réduction globale des émissions de gaz à effet de serre de 55% à la même date . À cette fin, Bruxelles et certains États membres investissent des millions d'euros pour inciter les propriétaires de voitures à passer à l'électrique. Quelques pays vont encore plus loin en proposant d'interdire les ventes de véhicules diesel et essence dans un proche avenir (dès 2025 dans le cas de la Norvège). Si tout se passe comme prévu, la possession de véhicules électriques en Europe pourrait passer d'environ 2 m aujourd'hui à 40 m d'ici 2030.

Donc en Europe on cherche aussi beaucoup... et on trouve !

Au Portugal notamment, qui produit actuellement 400 tonnes de minerai par an, mais dont les réserves sont prometteuses. Dans la région de Trás-os-Montes, au nord du Portugal, un gisement estimé à plus de 60 000 tonnes a été identifié.

En France, de récentes analyses montrent que l'Alsace pourrait bien assurer l'indépendance du pays en lithium.

Dans les eaux chaudes puisées en profondeur, Electricité de Strasbourg et le groupe Fonroche, deux acteurs de la géothermie profonde en Alsace, ont mesuré des concentrations élevées de lithium.

L'industriel français Fonroche Géothermie, "vient de procéder aux analyses complémentaires dans les eaux extraites de ses puits de forage situés sur la commune de Vendenheim, au Nord de Strasbourg. Les résultats confirment la présence de lithium en qualité et quantité très prometteuse lui permettant d'envisager une production annuelle de quelque 1 500 tonnes de Lithium propre sur ce seul ouvrage. Les besoins actuels en lithium de l’industrie française étant de 15.000 tonnes par an, 10 forages géothermiques suffiraient donc pour satisfaire la consommation de ce métal stratégique par l’Hexagone."

Sauf que, suite à une vague de petits séismes ressentis ces dernières semaines au nord de Strasbourg, la société de géothermie Fonroche doit faire face aux questions des habitants et des autorités sur un lien éventuel entre ses forages et les secousses observées dans cette zone. Une expertise est en cours.

Avec le lithium, la pollution change de camp ?

Hélas, chaque nouvelle source d'énergie apporte son lot de mauvaises... nouvelles.

La course au lithium n'est pas sans inspirer quelques craintes aux défenseurs de la nature. L'impact de l'exploitation minière moderne sur l'environnement naturel est parfois dramatique.

Au Portugal justement, la guerre est déclarée entre, d'une part les industriels et une partie de la population qui font valoir la manne financière attendue (plus d'un milliard et demi sur 11 ans), les emplois créés, l'économie de 100 millions de tonnes de CO2 (via les véhicules électriques), et d'autre part les défenseurs des sites ciblés au coeur d'une région idyllique du nord du Portugal :

" La vue sur le Peneda-Gêres, seul parc national du Portugal et réserve de biosphère pour l'Unesco, est à couper le souffle. Les pentes granitiques de la serra plongent dans les eaux cristallines du barrage de Paradela, en contrebas de hauts plateaux tour à tour boisés et pelés, terrains de jeu des meutes de loups et des hardes de garranos. Plus loin serpentent des gorges vertigineuses sur lesquelles veillent les aigles royaux."

En ces lieux, "les projets de mines de lithium promettent de creuser les montagnes alentour jusqu'à 300 mètres de profondeur."

Pour l'instant, le lithium portugais n'est pas rentable (face à celui du Chili par exemple), mais ce n'est qu'une question de temps. Gageons que les 60 000 tonnes (au moins) du métal alcalin ne resteront plus longtemps enfouis dans le sous-sol portugais, d'autant que l'Europe a un besoin vital d'une ressource à portée de mains.

"S'approvisionner en lithium dans son arrière-cour offre non seulement à l'Europe une logistique plus simple et des prix plus bas, mais aussi moins d'émissions liées au transport. Il promet également la sécurité d'approvisionnement du l'Europe - un problème d'autant plus urgent que la pandémie de coronavirus perturbe le commerce mondial."

Alors quelle solution pour réconcilier les deux parties ? Les industriels proposent de remettre le site en l'état (renaturalisation) après les 10 ans d'exploitation.

Des projets fort peu écologiques aux USA !

"Faire sauter une montagne n'est pas vert"

Les batteries Li-ion ont à ce jour des performances inégalées dans trois domaines : la densité d'énergie, une faible auto-décharge et le nombre de cycles de charge.

Le fort développement de la demande en véhicules totalement ou partiellement électrifiés, conduit donc à une explosion de la consommation de lithium.

Les Etats- Unis, qui produisent très peu du précieux métal alcalin, soucieux d'assurer leur indépendance énergétique, se lancent à corps perdu dans la recherche de gisements de lithium...

... quitte à faire de gros dégâts dans l'environnement.

Ainsi dans le nord du Nevada, des ouvriers ont commencé à creuser une fosse géante qui sera la première mine de lithium à grande échelle aux États-Unis.

La mine, construite sur des terres fédérales louées, pourrait contribuer à réduire la dépendance quasi totale des États-Unis à l'égard de sources étrangères de lithium .

Mais ce projet, connu sous le nom de Lithium Americas, validé par Trump, a suscité des protestations de la part des membres de tribus amérindiennes, d'éleveurs et de groupes environnementaux, car il devrait utiliser des millions de m3 d'eau souterraine, et contaminer potentiellement une partie de ces terres pendant 300 ans, en laissant derrière lui un monticule géant de déchets.

Si la disparition des moteurs thermiques est un impératif écologique majeur (émission de CO2, mais aussi de particules fines, d'oxydes d'azote...), le problème d'une production et d'une utilisation verte d'électricité est loin d'être résolu.

Depuis l'apparition des "gilets jaunes" il est de bon ton de fustiger la voiture électrique. En fait peu de gens comprennent que ce sont principalement les polluants émis à l'échappement des véhicules qui sont très problématiques pour la santé publique (400 000 morts par an en Europe).

Coupons court au suspens : une voiture électrique (y compris la fabrication de ses batteries) émet jusqu'à 3 fois moins de gaz à effet de serre (GES) et encore moins de polluants atmosphériques que les voitures à moteur thermique (essence ou diesel) suivant différentes études.

Si le bilan environnemental de la production de lithium a souvent été négligé, c'est en partie parce que les États-Unis, la Chine, l'Europe, sont engagés dans une course de vitesse.

Néanmoins, les investissements colossaux dans les véhicules électrifiés bénéficient à la recherche qui avance à grand pas dans le domaine du stockage de l'énergie et des batteries.

Pour la production de lithium même, il existe des options plus respectueuses de l'environnement - comme l'extraction de la saumure de lithium, au lieu des mines à ciel ouvert.

Extraire le lithium proprement, c'est possible !

L'extraction de lithium à partir de saumure est utilisée depuis longtemps au Chili, en Bolivie et en Argentine, où le soleil est utilisé pendant près de deux ans pour évaporer l'eau des étangs tentaculaires. Il est relativement peu coûteux, mais il utilise beaucoup d'eau dans les zones arides.

L'approche prévue sur la mer de Salton - un lac gigantesque horriblement pollué - est radicalement différente de celle traditionnellement utilisée en Amérique du Sud.

Ce lac se trouve au sommet des Salton Buttes (volcans souterrains).

"Le désert de Californie est jonché de restes de rêves brisés - villes fantômes cachées, mines abandonnées et restes rouillés de la grande idée de quelqu'un. Mais rien n'est plus grand sur un paysage abandonné que la mer de Salton, qui languit dans un coin négligé de l'État.

L'eau scintille et gronde dans le désert comme une réprimande: née de l'erreur humaine, aggravée par 100 ans de négligence et de pollution.

Le plus grand lac de Californie est également l'un de ses pires fléaux environnementaux, présentant un problème tellement inversé que son héritage toxique s'intensifie à mesure que ses eaux sales disparaissent.

Depuis des générations, les habitants de l'Imperial Valley respirent un tableau périodique des minéraux et des métaux, ainsi que des produits chimiques agricoles. Mais malgré toute la misère que ces eaux déchaînées ont déchaînée - l'asthme et autres affections respiratoires déclenchées par des nuages de poussière - la mer de Salton offre désormais une issue potentielle: [le] lithium, appelée «or blanc», l'un des éléments les plus précieux de la planète. , utilisé pour fabriquer des batteries qui alimentent les voitures électriques et conduisent un avenir sans combustibles fossiles."

Pendant des années, la société CalEnergy et Energy Source, ont exploité la chaleur géothermique des Buttes pour produire de l'électricité. Les systèmes utilisent de la vapeur souterraine naturelle et cette eau est chargée en lithium.

Le nouveau projet consiste à valoriser les eaux usées en récupérant le lithium après le passage de l'eau dans les centrales géothermiques, selon un processus qui ne prendra qu'environ deux heures.

Plusieurs entreprises travaillant sur la technique d'extraction directe du lithium - dont Lilac Solutions, basée en Californie et Standard Lithium à Vancouver (Colombie-Britannique) sont convaincues de l'avenir de cette technologie.

Standard Lithium exploite une source de saumure déjà extraite du sol par une usine chimique de l'Arkansas, qui n'a donc pas besoin de prélever d'eau supplémentaire du sol.

Standard Lithium, espère que l'entreprise produira 21 000 tonnes de lithium par an en Arkansas d'ici cinq ans... si elle parvient à lever 440 millions de dollars de financement.

Lilac Solutions, travaille également sur l'extraction directe de lithium au Nevada, au Dakota du Nord et dans d'autres sites américains qu'elle ne divulgue pas. La société prévoit que d'ici cinq ans, ces projets pourraient produire environ 100 000 tonnes de lithium par an, soit 20 fois la production nationale actuelle.

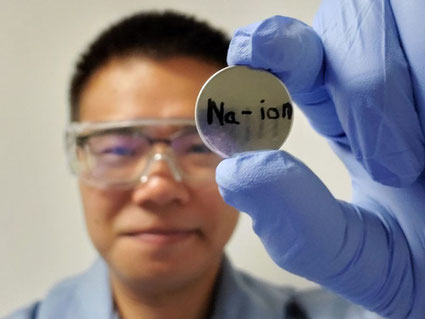

Après le lithium ?

Le véritable futur des batteries, c'est le remplacement du lithium par un autre métal alcalin : le sodium, particulièrement abondant et très peu coûteux.

La batterie sodium-ion présente encore toutefois des limites, et pas des moindres : non seulement elle ne peut stocker autant d'énergie qu’une batterie lithium, mais elle supporte aussi encore mal les charges à répétition.

Cependant, tout récemment, des chercheurs américains ont eu l’idée de créer un électrolyte liquide (la substance conductrice présente dans les batteries et qui contient les ions mobiles) dopé en ions sodium. Plus salé, le mélange semble mieux cohabiter avec la cathode, elle-même modifiée avec des oxydes métalliques en couche mince.

La nouvelle formule s’avére gagnante : avec des ions sodium en mesure de se déplacer de façon fluide et continue, plus de croûte de cristaux formée au niveau de la cathode. Après 450 cycles de charge, leur batterie a aussi démontré qu’elle conservait une capacité de rétention d’énergie de 82%.

Reste maintenant à développer un process industriel... Le lithium a encore de beaux jours devant lui !

Le recyclage du lithium

Pour une voiture équipée d’une batterie de 48 kWh (environ 320 Km d’autonomie), il faut donc 5,4 Kg de lithium (28,8 kg de carbonate de Lithium).

Aujourd'hui, jusqu'à 95% des constituants des batteries au lithium peuvent être recyclés.

En France, le taux de recyclage des batteries au lithium atteint aujourd'hui plus de 65 %. Renault affirme valoriser plus de 85 % du cobalt de ses batteries électriques.

Le lithium ne représente qu'une petite partie du coût de la batterie. Actuellement, le recyclage du lithium coûte plus cher que son extraction du sol ; l'un des principaux coûts se situe à la fin du processus: la transformation du lithium récupéré de son état recyclé (sulfate de lithium) en une forme prête à l'emploi (carbonate de lithium).

Pour les usines de recyclage existantes, le lithium n'est pas ce qui rapporte. L'objectif principal est de récupérer le cobalt, ainsi que le nickel et le cuivre.

Néanmoins, il est très important de recycler le lithium des batteries, ne serait-ce que pour limiter les dégâts infligés à la nature par l'industrie minière, d'autant que la demande va exploser dans la prochaine décennie.

IV - Des transports propres

Quand on se penche sur ce dossier, on est accablé par le volume des statistiques, des bilans, des projections... et des magnifiques envolées lyriques, qui sont souvent autant de pétitions de principe !

Comme pour le bâtiment, on est aussi consterné de constater qu'il aura fallu attendre le mitan des années 2010, pour que les lourdes machines administratives des Nations Unis, de la Commission Européenne et des états, se mettent en branle et proposent quelques perspectives pour sortir du tout pétrole qui nous empoisonne aujourd'hui.

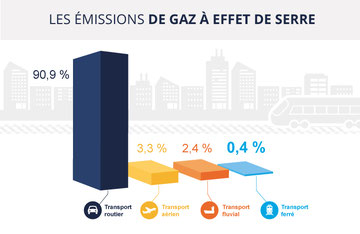

Les transports émettent très majoritairement du dioxyde de carbone (CO2) (environ 13,5 gigatonnes émises en 2016).

Selon l'Agence internationale de l'énergie, les transports représentent environ 14% des émissions de gaz à effet de serre et 23% des rejets de CO2 (38% en France : avec le nucléaire, la France émet relativement peu de CO2 pour son chauffage et son électricité). Ces chiffres ont augmenté de 2,5 % par an entre 2010 et 2015.

Les transports routiers (voitures, camions, etc.) demeurent les principaux responsables de ces émissions de gaz à effet de serre, loin devant le transport aérien ou maritime, également en constante augmentation.

En France, c'est ainsi le transport routier qui est l'activité émettant le plus de CO2 : 122 millions de tonnes en 2017, selon les chiffres de l'INSEE.

Les émissions de CO2 sont reparties à la hausse en 2017, la concentration du dioxyde de carbone atteint aujourd'hui les 400 ppm. Il faut savoir que ce gaz séjourne environ un siècle dans l'atmosphère.

Les actions internationales

La première Conférence mondiale sur le transport durable s'est déroulée en novembre 2016, au Turkmenistan.

Une réunion sympathique organisée par l'ONU, qui aboutit à une volonté réaffirmée : "Mobiliser le transport durable pour le développement", avec quelques recommandations, et à un constat : "ce n'est pas le financement qui fait défaut mais les projets de qualité ".

La Banque Mondiale disposerait de plus de fonds qu'elle n'en dispense pour le secteur du transport durable.

C'est dire le degré de mobilisation des gouvernements dans le domaine !

D'autre part l'ONU indique que " Dans le Programme de développement durable à l'horizon 2030, les transports durables sont intégrés dans plusieurs objectifs de développement durable, en particulier ceux liés à la sécurité alimentaire, la santé, l'énergie, la croissance économique, les infrastructures, les villes et les établissements humains. "

Dans le cadre de sa Plate-forme Initiative Climat (CIP), l'ONU a recensé une soixantaine d'initiatives d'envergure.

L'ICLEI (Conseil International pour les Initiatives Locales pour l'Environnement ), créé en 1990 sous l'égide des Nations-Unis, est un réseau mondial de villes et de régions engagées dans la construction d'un avenir durable. Elle est particulièrement active dans le domaine des transports. Elle regroupe 1500 villes et régions représentant un quart de la population du globe.

En 2016, la Banque mondiale, a appelé à une action pour accélérer les efforts visant à unifier et à transformer le secteur des transports. Elle a lancé un appel à l'action pour la mobilité durable pour tous et impulsé la création de Sustainable Mobility for All (SuM4All) qui regroupe aujourd'hui 56 organisations, ONG, banques, fédérations sportives, ministères, entreprises...

De nombreuses ONG se sont saisies du problème.

Par exemple, L'Alliance pour l'EcoMobilité qui a été créée en octobre 2011 en Corée. Elle regroupe 23 grandes villes et une quarantaine de fondations, universités, entreprises.... Elle agit pour la construction d'un avenir de transport durable garantissant des options de mobilité à faibles émissions de carbone, centrées sur l'homme et socialement inclusives.

Son siège est en Allemagne. En mai 2019, une Conférence Internationale sur l'écomobilité se tiendra à Heidelberg.

Tout cela est un peu foisonnant... Un peu trop ?

Au niveau européen

En 2015, les transports européens dépendaient du pétrole pour 94% de ses besoins en énergie. L'Europe importait environ 87% de son pétrole brut et de ses produits pétroliers de l'étranger, avec une facture d'importation estimée à environ 187 milliards d'euros.

La transition énergétique est donc aussi un impératif économique majeur pour l'Europe.

L'UE publie à jet continu sur le sujet depuis 5 ans. Directives, réglementations, appels à projets, conférences, forums... se sont multipliés. Il n'est pas simple de démêler bonnes intentions et actions.

En juillet 2016, la Commission dévoile sa stratégie pour la mobilité à faibles émissions :

- Accroître l'efficacité du système de transport en tirant le meilleur parti des technologies numériques, de la tarification intelligente et en encourageant davantage le passage à des modes de transport moins polluants,